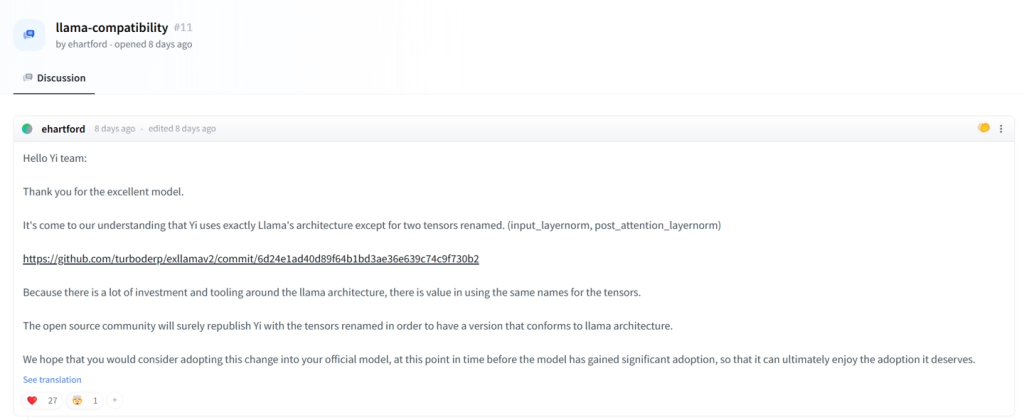

AIBetas消息,11月6日,开发者 ehartford Hugging Face社区的Yi-34B项目讨论区留言,指出该团队的项目除了两个张量重新命名外,完全使用了Llama的架构。

ehartford 称该模型使用了 Meta LLaMA 的架构,只对两个张量(Tensor)名称进行了修改,分别为 input_layernorm 和 post_attention_layernorm。ehartford 表示开源社区肯定会重新发布 Yi 大模型,并重命名张量以符合 LLaMA 架构。他希望该公司在模型获得大量采用之前考虑将这一更改应用到官方模型中,下方则引来了多方议论。

同日,网上流传的图片显示,前阿里巴巴副总裁、知名AI框架大牛贾扬清发朋友圈,感慨做小公司不容易,希望国内企业如果就是开源的模型结构,不要做换名伪装,免得小公司做一些多余的适配工作。消息一传开,一波或多或少基于Llama“魔改”的国产大模型纷纷躺枪。贾扬清专门留言辟谣不是老东家阿里。“大厂”究竟指谁众说纷纭,被“提名”较多的怀疑对象是上周刚发布首款预训练大模型Yi-34B的AI 2.0公司零一万物。零一万物创立于今年7月,由李开复带队创办并担任CEO,其开源发布的Yi-34B模型目前在Hugging Face的Open LLM Leaderboard开源大语言模型排行榜排名第一。

对此,零一万物回应:GPT是一个业内公认的成熟架构,Llama在GPT上做了总结。零一万物研发大模型的结构设计基于GPT成熟结构,借鉴了行业顶尖水平的公开成果,由于大模型技术发展还在非常初期,与行业主流保持一致的结构,更有利于整体的适配与未来的迭代。同时零一万物团队对模型和训练的理解做了大量工作,也在持续探索模型结构层面本质上的突破。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END

暂无评论内容